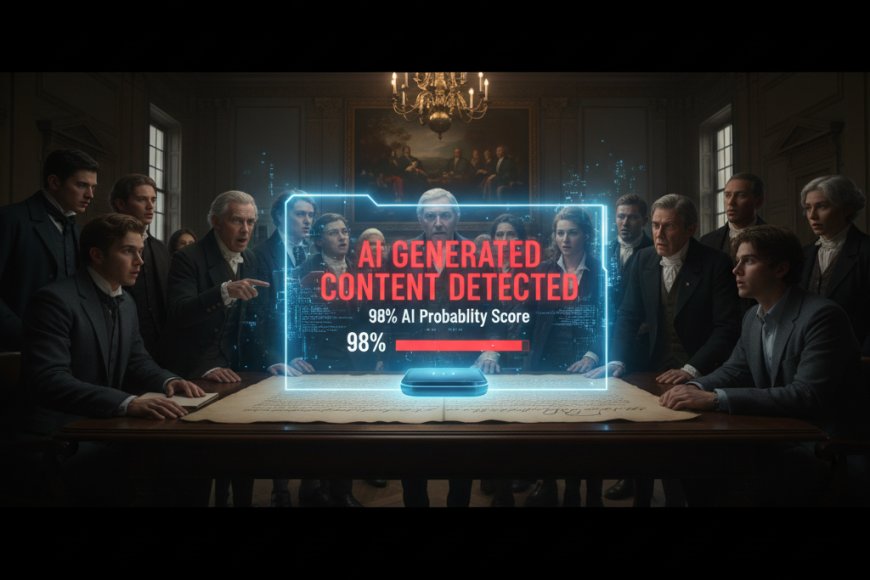

In un ironico errore epocale che ha fatto il giro del mondo accademico e tecnologico, un popolare strumento di rilevamento di intelligenza artificiale ha etichettato uno dei documenti fondativi della storia occidentale come un prodotto della moderna automazione algoritmica. Il software ha segnalato la Dichiarazione di Indipendenza americana, redatta da Thomas Jefferson nel 1776, con un'altissima probabilità di essere stata generata da un Large Language Model (LLM) come ChatGPT. L'incidente, venuto alla luce grazie a professori e studenti che testavano l'affidabilità di questi strumenti nei primi mesi del 2024, ha portato a una discussione globale sui limiti tecnici e le implicazioni etiche dei detector di contenuti AI.

L'errore non è frutto di un guasto, ma di una debolezza intrinseca del principio su cui si basano questi detector. La maggior parte di essi non confronta il testo con un database di contenuti AI (cosa impossibile data la velocità di generazione), ma analizza le caratteristiche statistiche del linguaggio. Cercano un'elevata "perplessità" (prevedibilità delle parole) e, crucialmente, una bassissima burstiness, ovvero un ritmo uniforme e una lunghezza delle frasi costante. I LLM tendono a scrivere con una fluidità e una coerenza sintattica quasi perfetta, evitando le variazioni, gli strappi e le imperfezioni tipiche della prosa umana.

Il linguaggio formale e didascalico della retorica del Settecento, in particolare nei documenti legali e politici, è caratterizzato da una sintassi precisa, da un vocabolario elevato e da una struttura argomentativa impeccabile. Queste caratteristiche, che all'epoca rappresentavano il culmine della maestria umana, imitano involontariamente i pattern di coerenza che i moderni LLM sono stati addestrati a replicare. Il risultato è che il linguaggio artificiosamente formale di Jefferson è stato confuso con l'uniformità statistica del codice. Il software, in sostanza, non riesce a distinguere tra l'eleganza di un'epoca passata e l'efficienza di un algoritmo contemporaneo.

Le conseguenze di questo false positive sono particolarmente gravi in ambito educativo. Molte università e scuole secondarie hanno iniziato a utilizzare i detector come arma per contrastare l'uso non autorizzato di ChatGPT nei compiti e nelle tesi. Tuttavia, l'incidente della Dichiarazione di Indipendenza, insieme a numerosi altri casi di false positive che coinvolgono scritti di studenti che non hanno usato l'AI, dimostra che affidarsi a questi strumenti mina l'integrità accademica invece di proteggerla. La decisione di un docente basata sull'output di un detector non è supportata da una prova scientifica, ma solo da una stima statistica fallibile.

L'episodio ci costringe a rivalutare la definizione stessa di "prosa umana" e di "originalità". Se il linguaggio più formale e preciso viene etichettato come meccanico, l'unico modo per un essere umano di provare la propria autenticità sembra essere l'introduzione deliberata di variazioni e imperfezioni.

Alla fine, la vera ironia è che, cercando di smascherare la macchina, l'AI detection finisce per condannare come non autentica la stessa voce umana e storica che ha dato origine al linguaggio che le macchine hanno imparato a imitare.