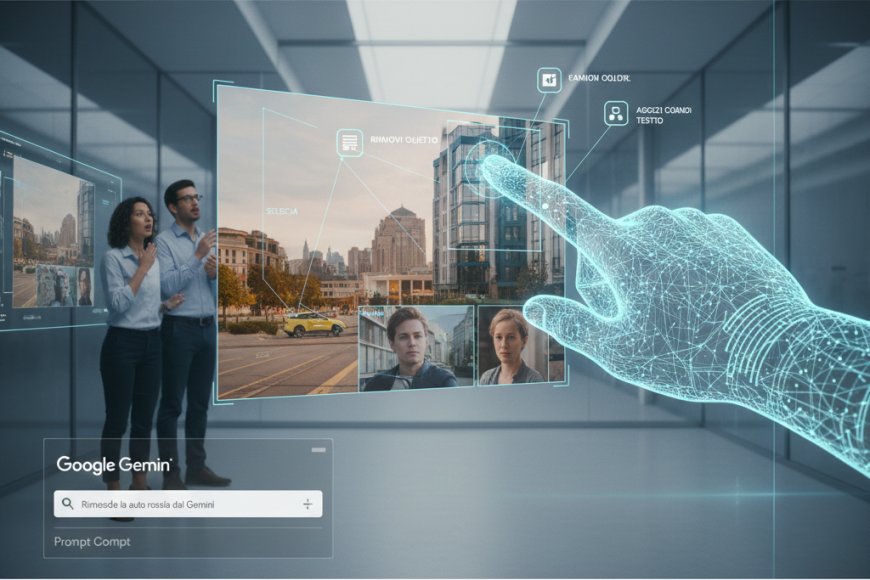

L'evoluzione dell'intelligenza artificiale sta portando il concetto di interfaccia utente verso una dimensione puramente visiva e intuitiva. Google ha recentemente presentato una nuova funzionalità per il suo modello Gemini che consente agli utenti di interagire con le immagini attraverso comandi visivi diretti. Questa tecnologia permette di selezionare aree specifiche, cerchiare oggetti o indicare elementi all'interno di una foto per richiedere modifiche, analisi o generazioni contestuali. Non si tratta più di descrivere a parole ciò che si vede, ma di agire direttamente sullo spazio grafico per guidare l'azione dell'algoritmo.

Questa innovazione si basa su un avanzamento significativo della comprensione multimodale del modello. Gemini non analizza più l'immagine come un blocco statico di dati, ma è in grado di mappare le coordinate spaziali degli elementi presenti e di metterle in relazione con le istruzioni dell'utente. Se un utente cerchia un oggetto in uno scatto complesso e chiede di sostituirlo o di descriverlo, l'AI comprende l'esatta posizione e il contesto circostante, agendo con una precisione chirurgica che in passato richiedeva lunghi e complessi processi di post produzione manuale.

L'impatto pratico di questo aggiornamento è vasto, specialmente nel campo della produttività e del design. Gli utenti possono ora utilizzare Gemini per modificare presentazioni, ritoccare foto personali o analizzare diagrammi tecnici semplicemente "puntando" gli elementi d'interesse. Questa modalità di interazione riduce drasticamente l'attrito tra l'intenzione umana e l'esecuzione della macchina, rendendo l'intelligenza artificiale uno strumento molto più naturale e accessibile. La barriera linguistica del prompt testuale, spesso difficile da formulare per descrizioni visive complesse, viene superata dalla naturalezza del gesto grafico.

Parallelamente, questa funzionalità apre nuove frontiere per l'accessibilità e la ricerca. La capacità di Gemini di identificare e operare su dettagli specifici indicati visivamente può supportare ipovedenti nella navigazione di contenuti digitali o aiutare i ricercatori a catalogare reperti e dati complessi in modo più rapido. La sfida per Google sarà ora garantire la sicurezza e la privacy in queste interazioni, assicurando che l'analisi spaziale dei contenuti avvenga nel rispetto dei dati sensibili dell'utente e prevenendo utilizzi impropri della manipolazione visiva istantanea.

Alla fine, la trasformazione del prompt da testo a segno grafico segna il passaggio verso un'informatica più vicina alla percezione umana. Se l'immagine diventa l'interfaccia stessa, il modo in cui comunichiamo con le macchine è destinato a diventare sempre più fluido, immediato e profondamente visivo.