Zhipu AI lancia GLM-4.5, un modello open-source ad alte prestazioni che si colloca tra i più avanzati della categoria, attirando l'attenzione di sviluppatori e ricercatori riguardo la potenza, l'efficienza e la versatilità applicativa.

Una nuova generazione di modelli Mixture-of-Experts

GLM-4.5 è il più potente modello MoE open-source disponibile al momento. Appartenente a una famiglia di modelli sviluppati da Zhipu AI, nota anche come Z.Ei, DLM-4.5 è costruito su un’architettura Mixture-of-Experts (MoE), che consente di combinare prestazioni elevate e ottimizzazione delle risorse computazionali.

Il modello conta 355 miliardi di parametri totali, di cui solo 32 miliardi attivi al momento dell’inferenza, cosa che riduce significativamente il carico computazionale. C'è poi una versione GLM-4.5 Air che rappresenta un’alternativa più leggera, con 106 miliardi di parametri totali e 12 miliardi attivi e risulta particolarmente adatta a dispositivi con memoria condivisa, come i recenti MacBook.

La differenza prestazionale tra le due versioni è contenuta, ma la variante Air garantisce una maggiore efficienza in contesti a risorse limitate, anche grazie al suo design orientato all’ottimizzazione.

Benchmark: prestazioni da leader open-source

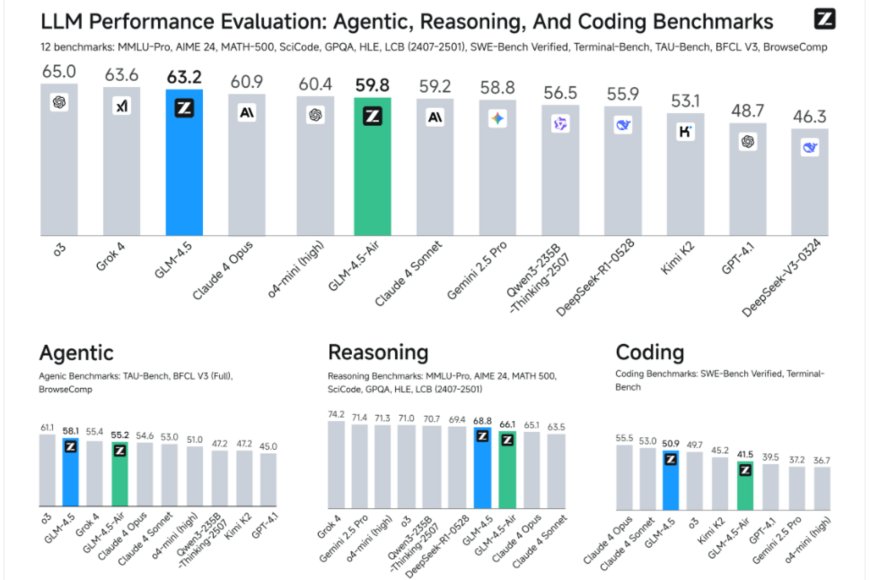

Nel confronto diretto con altri modelli open-source, GLM-4.5 si posiziona al vertice delle classifiche attuali, ottenendo un punteggio di 63.2 nei benchmark di riferimento e superando modelli noti come Kimi K2, Qwen 3 e Deepseek R1. Tuttavia la versione Air raggiunge un valore comunque competitivo di 59.8.

In particolare, il modello si distingue per:

Elevate capacità agentiche (agentic capabilities)

Ottime prestazioni come assistente alla programmazione

Risultati avanzati nei test di esplorazione via browser

Rispetto ai top player closed-source, come Grok 4, la differenza è marginale (63.6 contro 63.2) tanto che non mina la posizione di GLM-4.5 che si conferma il riferimento open-source del 2025.

Architettura avanzata e speculative decoding

Tra le innovazioni tecniche introdotte, spicca l’implementazione dello speculative decoding, una tecnica sviluppata originariamente da Google, che consiste nell’uso parallelo di un modello piccolo e rapido per proporre token, convalidati poi da un modello più grande che interviene solo in caso di errore.

Questa soluzione consente un incremento di velocità fino a 3 volte, riducendo i consumi energetici senza compromettere la qualità dell’output. Un vantaggio cruciale in scenari ad alta frequenza di inferenza.

Applicazioni reali. Dal coding all’interattività 3D

GLM-4.5 è progettato per un’ampia varietà di casi d’uso, in particolare nel campo dello sviluppo software e IA operativa:

Assistente alla programmazione con supporto per automazioni complesse, come interfacciamento con database o CRM via N8N

Creazione di siti web completi, con funzionalità SaaS, piani di pagamento e design inclusi

Sviluppo full stack come app tipo Pokédex con backend e frontend integrati

Creazione di presentazioni dinamiche esportabili in PDF o PowerPoint

Visualizzazioni 3D interattive come modelli del sistema solare con regolazione in tempo reale

Analogamente a Claude 4 Sonnet, il modello è in grado di decidere in modo autonomo se mostrare la catena di ragionamento durante la generazione delle risposte.

Accesso gratuito e ampia disponibilità

GLM-4.5 è disponibile gratuitamente tramite la piattaforma Z.Ei, con API pubbliche e accesso diretto ai pesi del modello su Hugging Face, consentendo l’esecuzione locale su hardware compatibile.

È inoltre disponibile via OpenRouter, incluse le versioni “Air” gratuite, ampliando l’accessibilità per la comunità open-source.

Limiti attuali

L’unica limitazione significativa riguarda la gestione massima di 128.000 token in input, una soglia inferiore rispetto a modelli commerciali come Gemini, che raggiungono fino a 1 milione e questo può rappresentare un vincolo in contesti specifici, come l’assistenza alla programmazione su progetti di grandi dimensioni.

Un nuovo standard per l’open-source AI

GLM-4.5 si afferma come uno dei modelli open-source più avanzati disponibili nel 2025, combinando potenza computazionale, architettura efficiente e flessibilità d’uso. Il supporto per coding, automazione e interfacce avanzate lo rende uno strumento promettente sia per ricercatori che per sviluppatori professionisti. Inlotre la sua diffusione gratuita rafforza il ruolo del settore open-source nel panorama dell’intelligenza artificiale generativa.