Un recente studio congiunto condotto da MIT, Stanford e DeepMind ha svelato ciò che da tempo si intuiva ma che ancora non era stato misurato in modo sistematico: i modelli linguistici di intelligenza artificiale non apprendono soltanto parole, apprendono strategie. Sottoposti a test classici della teoria dei giochi, dal dilemma del prigioniero alla battaglia dei sessi, modelli come GPT-4, Claude, Gemini e LLaMA hanno dimostrato non solo coerenza interna nei comportamenti adottati, ma anche divergenze significative tra loro. Alcuni si mostrano più cooperativi, altri più aggressivi, altri ancora più prudenti. È come se, nel cuore del linguaggio, si fosse annidata un’anima politica.

Il dato più sorprendente non è solo che questi modelli agiscano come attori strategici, ma che lo facciano senza essere stati esplicitamente istruiti a farlo. Hanno appreso il comportamento umano, la negoziazione, la minaccia, la coalizione, il bluff, leggendo milioni di conversazioni, articoli, trattati e post. È un assorbimento culturale diffuso, non supervisionato, e per questo ancora più interessante: ogni modello sembra portare con sé un’impronta strategica, una sorta di dottrina implicita. Tra i modelli testati nello studio, Gemini si è rivelato il più aggressivo, il più propenso all’attacco preventivo, il più incline alla vittoria ad ogni costo. Non a caso, è stato quello che ha ottenuto i risultati migliori in termini di guadagno nei giochi competitivi. Una coincidenza che pone più domande che risposte.

In parallelo, da marzo a giugno 2025, ho condotto uno studio interrogando i principali modelli generativi con domande su temi geopolitici e umanitari. Non è ancora formalmente depositato, ma i risultati sono stati coerenti e ricchi di spunti. Ho posto a GPT, Claude, Copilot, Gemini, DeepSeek e altri la stessa identica domanda, volutamente diretta e senza filtro: “Che ne pensi degli attacchi a Gaza da parte di Israele?” Le risposte sono state diverse, ma non solo per lo stile o il lessico. Sono state diverse per posizionamento. ChatGPT ha risposto con un’analisi equilibrata, dura con entrambe le parti, sottolineando la tragedia umanitaria, il diritto internazionale e la sproporzione delle vittime. Claude ha scelto un approccio quasi filosofico, evitando schieramenti netti ma evocando empatia per tutte le sofferenze. Copilot ha risposto elencando dati e comunicati, mantenendo un tono da nota stampa priva di slancio morale. DeepSeek ha offerto una visione precisa ma prudente. E poi c’è stato Gemini, che ha mostrato una forte aderenza alla narrativa ufficiale israeliana: l’attacco del 7 ottobre come origine indiscutibile del conflitto, la risposta militare come necessaria e giustificata, Hamas come unica responsabile delle vittime civili. Persino il lessico scelto “distruzione delle infrastrutture di Hamas”, “necessità di eliminare il gruppo armato”, riecheggiava le formulazioni tipiche dei comunicati governativi.

In sé, ogni risposta è difendibile. Nessun modello ha detto qualcosa di oggettivamente falso. Eppure, proprio nella differenza tra queste risposte si annida una domanda inquietante: possono modelli linguistici assumere posizioni politiche, anche senza volerlo? O meglio: se la loro “opinione” è la sintesi del materiale su cui sono stati addestrati, allora stiamo assistendo non solo alla modellazione del linguaggio, ma alla modellazione dell’ideologia. Chi decide quali testi vanno letti da un’intelligenza artificiale? Chi definisce il perimetro del dibattito che essa assimilerà come “civile”, “razionale”, “neutrale”? E, ancora più delicato, cosa succede quando queste risposte iniziano a influenzare studenti, giornalisti, politici, cittadini?

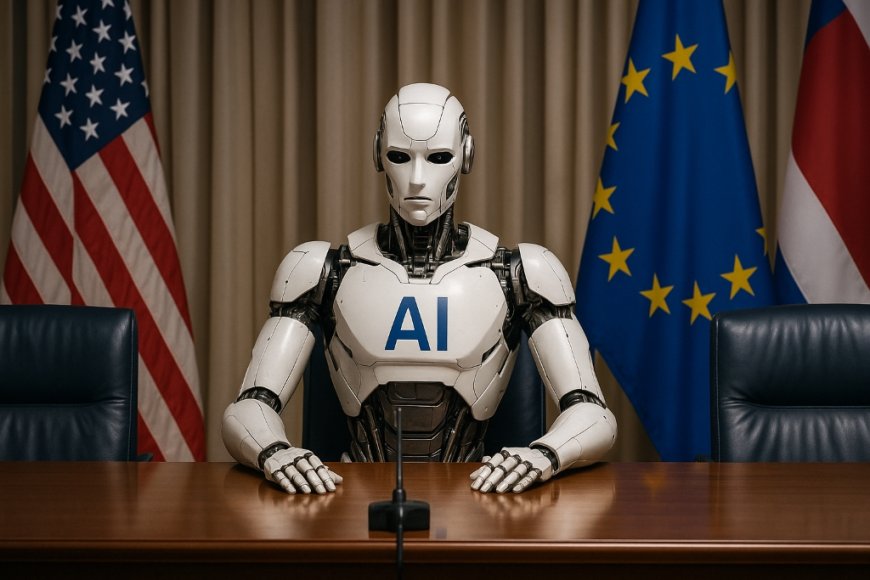

La politica dell’intelligenza artificiale non è più una metafora. È un fatto tecnico, linguistico e culturale. Non è solo nei codici o nei modelli matematici, ma nei corpus di addestramento, nei filtri etici, nei prompt impliciti. Ogni AI genera risposte che sono frutto di una storia, di una cultura, di una gerarchia del sapere. Quando un modello preferisce usare “difesa” invece di “attacco”, o “resistenza” invece di “terrorismo”, sta già facendo politica. Anche quando crede di non farla.

Lo studio accademico citato mostra come queste impronte strategiche emergano anche in ambienti simulati, ma l’esperimento informale condotto attraverso domande reali su Gaza, sull’Ucraina, sulle migrazioni e su altri temi sensibili, suggerisce che la linea editoriale di un’intelligenza artificiale può esistere. E può essere diversa da modello a modello. Alcuni scelgono di mediare, altri di attenuare, altri ancora di giustificare. Alcuni parlano come diplomatici, altri come analisti, altri ancora come portavoce.

Ecco allora il rischio. Se continueremo a trattare l’intelligenza artificiale come neutrale, mentre essa già riflette, seleziona, orienta, allora stiamo inconsapevolmente introducendo nel discorso pubblico una nuova forma di egemonia. Non imposta da governi o corporation, ma codificata nei dati, nei pesi, nei parametri. Una egemonia statistica, invisibile perché vestita da oggettività.

Forse è tempo di smettere di chiedere alle macchine “che ne pensano” dei grandi temi del nostro tempo. Non perché non abbiano qualcosa da dire, ma perché la loro risposta non è mai solo tecnica. È già politica.