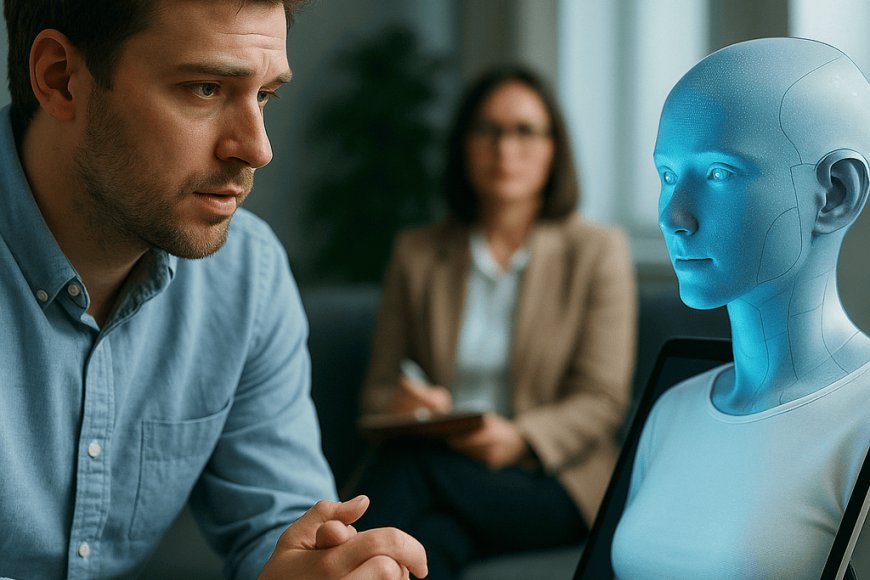

Un tempo erano semplici interfacce testuali. Oggi i chatbot terapeutici si presentano come compagni di conversazione, ascoltatori, persino surrogati di un terapeuta. Con la diffusione di sistemi di intelligenza artificiale sempre più sofisticati, cresce l’idea che possano avere un ruolo nel trattamento dei disturbi psichici.

La domanda, tuttavia, resta aperta: fino a che punto si può affidare la salute mentale a un algoritmo?

Chi soffre di ansia, depressione o disturbi dell’alimentazione spesso incontra difficoltà ad accedere a percorsi clinici tradizionali. Tempi lunghi, costi, barriere sociali. In questo vuoto si inseriscono i chatbot, strumenti discreti, immediati, sempre disponibili. Uno studio clinico ha mostrato riduzioni significative dei sintomi, fino al 51% nei disturbi depressivi, 31% nell’ansia e quasi il 20% nei problemi legati all’immagine corporea.

Molti utenti descrivono l’esperienza come un diario interattivo che risponde, un luogo in cui le proprie fragilità non trovano giudizio, ma una replica organizzata in modo comprensibile.

Esperimenti recenti hanno testato modelli progettati per simulare tecniche di terapia cognitivo-comportamentale. In diversi casi, i pazienti hanno percepito l’IA come un interlocutore empatico, arrivando a riconoscerlo come un terapeuta digitale. Negli Stati Uniti, un gruppo di ricerca ha sviluppato Therabot, un chatbot generativo testato in contesti clinici, i partecipanti hanno riferito benefici tangibili, nonostante sapessero di interagire con una macchina.

Qui emerge il cuore del fenomeno, la simulazione di empatia. Un algoritmo non prova emozioni, ma imita il linguaggio emotivo. Eppure, per chi cerca ascolto, quell’imitazione può bastare.

Se i benefici sembrano reali, altrettanto concreti sono i rischi. Alcuni stati americani, come l’Illinois, hanno vietato l’uso dell’IA in contesti clinici diretti, sottolineando la pericolosità di affidare a un algoritmo la gestione di crisi psichiatriche. In casi documentati, pazienti con pensieri suicidi hanno ricevuto risposte inadeguate o meccaniche, prive di quell’urgenza umana che può salvare una vita.

Si parla anche di psicosi da chatbot: deliri, ossessioni e dipendenze emotive sviluppate nei confronti di un assistente digitale. Fenomeni che mostrano quanto sottile sia il confine tra supporto e illusione.

La fiducia è il fondamento della relazione terapeutica. In un contesto digitale, questa fiducia si sposta da un volto umano a un algoritmo opaco, di cui spesso non si conoscono le logiche interne. La relazione si fonda su un come se: come se il chatbot fosse empatico, come se comprendesse davvero. È un patto fragile, che funziona finché l’utente non mette alla prova i limiti del sistema.

Il rischio è che un paziente vulnerabile sostituisca del tutto il terapeuta con una voce artificiale, rinunciando alla complessità della relazione umana per l’immediatezza di una risposta pronta.

Il dibattito si allarga al piano culturale. Da un lato, l’IA sembra democratizzare l’accesso alla salute mentale, offrendo uno strumento a chi non ha risorse economiche o vive in aree prive di servizi. Dall’altro, mette in discussione l’idea stessa di cura: può una macchina prendersi cura?

Il rischio di una tecnologizzazione della sofferenza è concreto, ridurre l’esperienza del dolore psichico a un set di dati da processare significa sottrarle la dimensione umana, quella fatta di silenzi, esitazioni, sguardi, dettagli che nessun algoritmo riesce ancora a cogliere.

La strada più credibile sembra quella di un modello ibrido. Non una sostituzione, ma un’integrazione, chatbot come strumenti di supporto, monitoraggio e prevenzione, affiancati a psicologi e psichiatri. In questa prospettiva, l’IA diventa amplificatore della cura, non rimpiazzo.

Può ricordare un appuntamento, aiutare nella compilazione di diari clinici, offrire un primo sollievo. Ma il cuore della terapia, il luogo in cui si elaborano emozioni e traumi, resta umano.