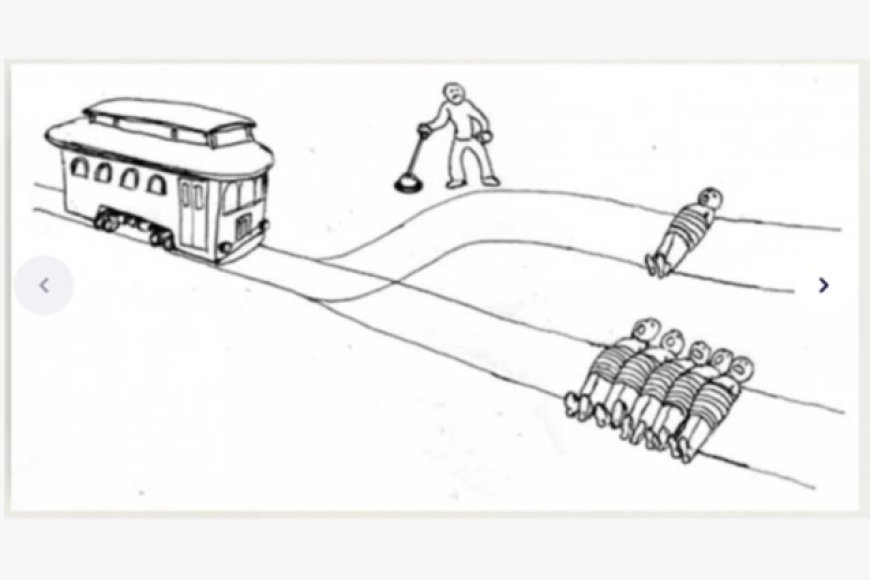

Fino a una decina di anni fa le conferenze di etica dell’intelligenza artificiale andavano più o meno così. Dopo che il relatore illustrava i principali risultati dell’intelligenza artificiale e le sfide più difficili di fronte a cui ci troviamo, veniva il momento di apprezzare il lato etico della faccenda. Il riferimento più comune era al cosiddetto “trolley problem”, ossia al “problema del carrello”. Si chiama così perché l’esperimento mentale di cui stiamo parlando prevede una decisione riguardante il percorso di un carrello ferroviario, come quello illustrato nella figura seguente.

In questo esperimento mentale si immagina uno scenario con un carrello ferroviario lanciato a tutta velocità lungo un binario e destinato a travolgere un gruppo di persone. L’osservatore, però, si trova accanto a uno scambio. Azionandolo, il carrello viene deviato su un binario secondario, dove si trova una sola persona. La situazione costringe a una scelta scomoda. Si tratta di scegliere se non intervenire affatto e lasciare che il carrello uccida il gruppo di persone, oppure intervenire attivamente causando la morte di una sola persona. La seconda scelta sembra “conveniente”, almeno in termini di calcolo delle conseguenze dell’azione. Ma bisogna essere disposti ad assumere una responsabilità individuale e a ragionare in termini utilitaristici. Il “trolley problem” è un modo per ragionare su tali intuizioni morali e di valutarne le conseguenze. Se fino a poco tempo fa questo genere di esercizi filosofici sembravano soltanto modi di disciplinare le nostre intuizioni morali (“Sei più utilitarista o deontologico?”), una decina di anni fa si erano trovati alcuni casi di applicazione concreta dovuti agli avanzamenti dell’intelligenza artificiale. Le prime automobili a guida autonoma erano l’esempio preferito. Si immagini una Tesla che si trova in una situazione analoga a quella descritta nel nostro esperimento mentale. Come dovrà comportarsi l’automobile? Il problema non è più solo speculativo. Si tratta di scrivere un software che sia ispirato all’etica utilitaristica oppure di fare il contrario. A quale etica dovranno ispirarsi gli sviluppatori del software delle aziende che forniscono i programmi di guida autonoma installati sulle automobili di nuova generazione? Il successo di questi esempi dipendeva anche dal fatto che rendevano visibile, in forma semplificata, l’idea allora ancora controversa che le decisioni delle macchine potessero avere un contenuto normativo.

Bisogna riconoscere che con questo genere di ragionamenti si forzava un po’ la mano. Raramente, infatti, le automobili a guida autonoma si trovano di fronte a una situazione come quella descritta precedentemente. Ma tant’è. Era un modo di sostenere che i dilemmi etici erano ormai entrati nelle software house e non erano più soltanto roba per filosofi. Il problema è complicato dal fatto che Jacques Bonnefon e i suoi colleghi hanno scoperto che in genere le persone sono utilitariste con le automobili degli altri, ma deontologiche con le proprie (Bonnefon, J. F., Shariff, A., & Rahwan, I., The social dilemma of autonomous vehicles. Science, 2016, 352(6293), 1573-1576). Detto altrimenti, l’utilitarismo sembra una buona idea presa in astratto, ma se si tratta della propria vita desideriamo che l’automobile si comporti mettendo in cima la sicurezza della nostra vita. Quale intuizione morale dovranno seguire gli sviluppatori dei software?

Benché risalga soltanto a dieci o venti anni fa, questo scenario è radicalmente mutato negli ultimi anni. Con l’avvento del “deep learning” e dell’AI generativa, l’inverno dell’intelligenza artificiale è definitivamente finito (Lighthill, J., Artificial intelligence: A general survey. In Science Research Council (Ed.), Artificial intelligence: A paper symposium (pp. 1–35), London: Science Research Council, 1973). L’AI è di nuovo al centro della scena e promette di cambiare la vita di ciascuno. La differenza rispetto al passato non riguarda solo la potenza dei sistemi, ma il loro carattere infrastrutturale. L’AI non è più confinata a singole applicazioni, ma attraversa ambienti, pratiche e decisioni quotidiane. Ci sono enormi opportunità, come ciascuno vede. Ma anche preoccupazioni di ogni sorta. Il lavoro è un ambito di preoccupazione centrale. Le mansioni lavorative che ciascuno svolge saranno rese obsolete dalle nuove tecnologie? Oppure potremo svolgerle meglio e più comodamente? La salute è un altro ambito in cui le opportunità e le paure sono mescolate. Saranno davvero più affidabili le macchine nella diagnosi e nella prescrizione delle cure rispetto alla loro controparte umana? Si può pensare che la democrazia sia minacciata dalle politiche di controllo rese possibili dall’intelligenza artificiale generativa. Si pensa meno a come le stesse tecnologie potrebbero favorire una partecipazione democratica dei cittadini che sembra sempre più vana, se affidata ai classici strumenti della democrazia liberale di massa. Quelli appena menzionati sono solo alcuni dei principali ambiti in cui lo sviluppo recente dell’intelligenza artificiale ha fatto sentire la sua influenza. Ma è ogni ambito dell’esperienza umana che sta misurando le proprie abitudini con la novità, dai giuristi agli economisti, fino ai semplici contabili. Tutti vogliono sapere se sono più minacciati o avvantaggiati dalla nuova AI.

Lo scorso mese è stata fondata una società che riunisce gli studiosi interessati a investigare i vari aspetti dell’etica e della politica dell’AI (Society for the Ethics and Politics of Artificial Intelligence, SEPAI, Roma Tre, 4 e 5 dicembre 2025, https://www.sepai-international.org). Il programma del primo convegno della società restituisce bene l’ampiezza e la crescente articolazione del dibattito di oggi rispetto a quello di una decina di anni fa. Si va dall’AI generativa all’arte e alla creatività, dalla medicina e dalla bioetica alle applicazioni militari e di difesa, dal lavoro e dall’automazione alle politiche pubbliche, alla regolazione giuridica e ai modelli di governance. Accanto a questi temi applicativi, trovano spazio anche questioni più teoriche, come la “spiegabilità” e la trasparenza dei sistemi computazionali, il rapporto tra reti neurali e comprensione, e i problemi filosofici legati alla coscienza, all’intenzionalità e alla responsabilità morale degli agenti artificiali.

Se fino a non molto tempo fa il compito dell’etica dell’intelligenza artificiale sembrava consistere nel convincere un pubblico scettico che l’AI avesse anche conseguenze morali, oggi la situazione si è capovolta. Non solo l’intelligenza artificiale è diventata parte ordinaria delle infrastrutture sociali, economiche e politiche che siamo soliti praticare, ma quasi ogni questione che emerge al confine tra informatica e società tende a essere formulata, fin dall’inizio, in termini etici. È questo spostamento di prospettiva, più che l’emergere di nuovi dilemmi spettacolari, a caratterizzare la fase attuale del dibattito.

L’etica dell’intelligenza artificiale. Da problema marginale a questione diffusa

Quando l’intelligenza artificiale diventa infrastruttura sociale, le questioni etiche smettono di essere marginali e attraversano ogni ambito dell’esperienza umana.

Condividi:

•

5 min di lettura