Più di 1.500 esperti e leader mondiali hanno unito la propria firma in un appello che chiede di sospendere lo sviluppo di sistemi di intelligenza artificiale generale finché non sarà assicurata la loro controllabilità e sicurezza. Tra i firmatari compaiono figure come Geoffrey Hinton e Yoshua Bengio, considerati pionieri dell’AI moderna, e Steve Wozniak, cofondatore di Apple. La richiesta parte dal presupposto che un’AI molto evoluta e autonoma possa rappresentare per l’umanità un rischio più grave di quanto finora discusso.

Nel documento si afferma che molte aziende puntano a sviluppare una “superintelligenza” nei prossimi anni, capace di superare l’uomo in compiti cognitivi generali. Il timore è che senza parametri chiari e salvaguardie robuste l’AI possa ridurre drasticamente l’autonomia umana, erodere diritti civili o persino minacciare la sopravvivenza della specie. I firmatari richiedono che i progressi vengano gestiti come un progetto mondiale, con criteri scientifici, partecipazione pubblica e rispetto delle conseguenze sociali.

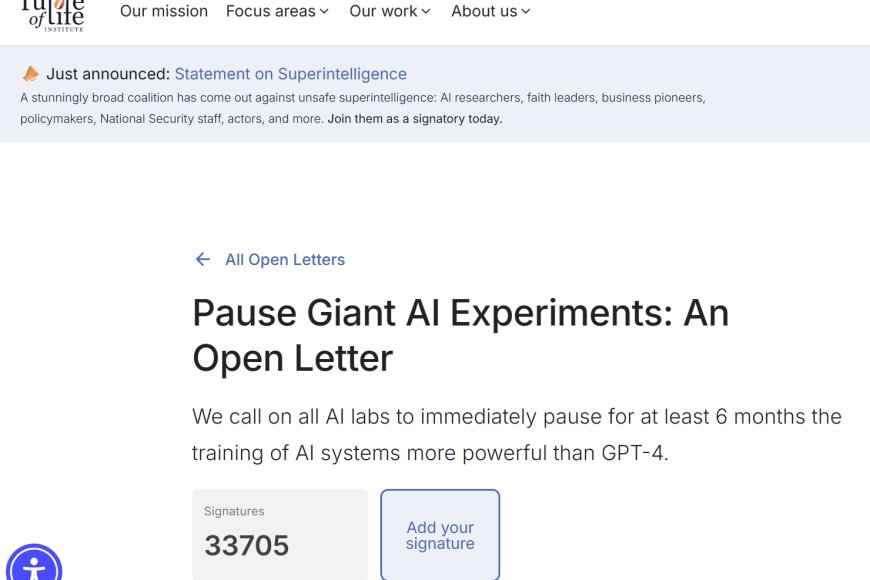

Questo tipo di moratoria non è una proposta nuova: già anni fa alcune organizzazioni legate all’AI avevano lanciato allarmi simili. Ma l’ampiezza e la composizione della lista odierna segnano un cambiamento rispetto al passato e riflettono una percezione più concreta del pericolo. La questione principale è che il progresso tecnologico, per quanto promettente, non cancella la necessità di governarlo e inserirlo in un contesto umano.

L’appello invita inoltre a rivedere la governance globale delle tecnologie più potenti: suggerisce limiti al calcolo utilizzato per addestrare modelli, controlli indipendenti sui sistemi in produzione e sistemi di “killer-switch” per fermare esperimenti pericolosi. Studi accademici recenti spiegano che una superintelligenza – se non contenuta – potrebbe generare scenari incontrollabili proprio per ragioni di complessità e potenza computazionale.

In definitiva, la sfida non è più solo tecnologica ma politica, sociale e morale: occorre decidere se l’AI debba essere un agente neutro al servizio dell’umanità o un fattore che trascenda la nostra capacità di comprensione e controllo.